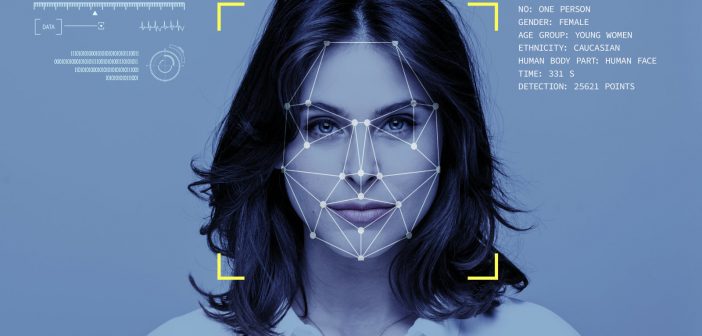

El fabricante Fujitsu ha anunciado que está desarrollando una nueva tecnología de reconocimiento facial con IA que detecta cambios sutiles en la expresión facial con mayor precisión, en lugar de basarse en una detección estática, y que aplica además algunas técnicas ingeniosas para mejorar la eficacia del aprendizaje. La nueva tecnología ha sido desarrollada en colaboración con la Facultad de Ciencias Computacionales de la Universidad Carnegie Mellon (USA), y puede detectar con precisión cambios emocionales sutiles, incluidas risas incómodas o nerviosas, confusión, etc., y también cuando la cara del sujeto se mueve en un contexto del mundo real.

Ya hay muchos sistemas que pueden detectar expresiones faciales para hacer una análisis del estado de ánimo; pero Fujitsu explica que su desarrollo tiene un enfoque original y que puede ayudar en multitud de casos de uso y aplicaciones que van desde mejorar la seguridad de los trabajadores de una fábrica o conductores de transporte, hasta el trabajo con robots, que podrán “entender” mejor a los propios humanos.

Según Fujitsu, uno de los obstáculos para la tecnología de reconocimiento de expresión facial es la dificultad de proporcionar grandes cantidades de datos necesarios para entrenar modelos de detección para cada pose facial, porque las caras generalmente se capturan con una amplia variedad de poses en aplicaciones del mundo real. Para abordar el problema, la tecnología de Fujitsu aplica procesos de normalización para, por ejemplo ajustar una imagen oblicua para que se parezca más a una imagen frontal del rostro, lo que permite que el modelo de detección sea entrenado con una cantidad relativamente pequeña de datos. La tecnología puede detectar con precisión cambios emocionales sutiles, incluidas risas incómodas o nerviosas, confusión, etc., y también cuando la cara del sujeto se mueve en un contexto del mundo real.

El espejo de las emociones

En los últimos años, las tecnologías que detectan cambios en la expresión facial o emociones a partir de imágenes han ido ganando cada vez más interés para crear sistemas orientados a retail o para detectar escenas clave en un vídeo. Los desarrollos existentes se han centrado en descubrir modificaciones claras en la expresión facial (por ejemplo, las comisuras de la boca y de los ojos, que se mueven ampliamente). En el futuro, se espera que este reconocimiento de expresión facial sea útil en entornos como el de la salud, para monitorización del paciente en la atención médica y el análisis de las respuestas de los clientes a los productos en las campañas de marketing.

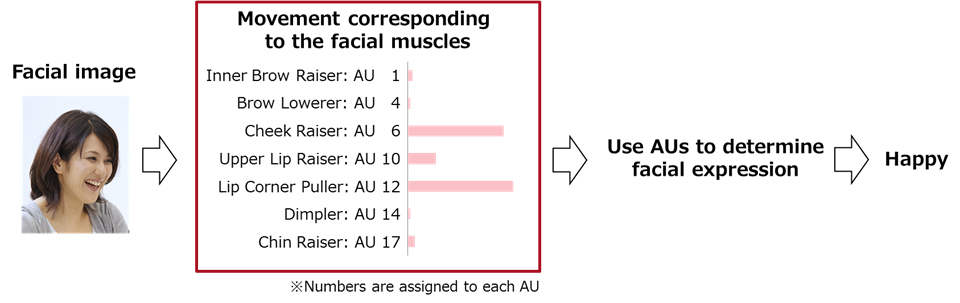

Controlando cada músculo del rostro

Como explica Fujitsu. para «leer» las emociones humanas de manera más efectiva, es importante capturar los sutiles cambios faciales asociados con las emociones, como la comprensión, el desconcierto y el estrés. Para lograr esto, los desarrolladores usan las llamadas Unidades de Acción (AUs), que expresan las «unidades» de movimiento correspondientes a cada músculo del rostro en base a un sistema de clasificación anatómico. Por ejemplo, las AUs han sido utilizadas por profesionales de la investigación psicológica y la animación 3D. Las AUs se clasifican en aproximadamente 30 tipos según los movimientos de cada músculo facial, incluidos los de las cejas y las mejillas. Al integrar estas AUs en su tecnología, Fujitsu segura que ha sido pionera en su enfoque para descubrir incluso cambios sutiles en la expresión facial. Para detectar AUs con mayor precisión, las técnicas subyacentes de aprendizaje profundo requieren grandes cantidades de datos.

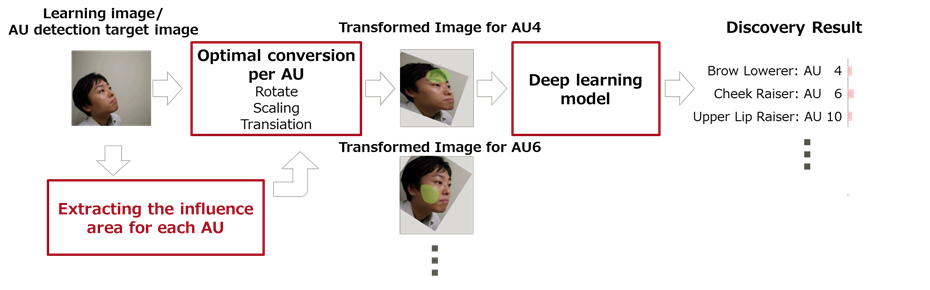

En situaciones del mundo real, las cámaras generalmente capturan caras en varios ángulos, tamaños y posiciones, lo que dificulta la preparación de datos de aprendizaje para los sistemas de inteligencia artificial. Es por ello que Fujitsu y la Facultad de Ciencias Computaciones de la Universidad Carnegie Mellon han desarrollado una tecnología que puede detectar AUs con alta precisión, incluso con datos de entrenamiento limitados, gracias Proceso de normalización para ajustar la cara para una mejor semejanza de la imagen frontal

Con esta tecnología, las imágenes de la cara tomadas en varios ángulos, tamaños y posiciones se giran, amplían o reducen y se ajustan de otra manera para que la imagen se parezca más a la frontal del rostro. Esto hace posible detectar AUs con una pequeña cantidad de datos de entrenamiento, basados en la vista frontal de la cara del sujeto.

Analizando las regiones significativas del rostro

En el proceso de normalización de las imágenes, el sistema convierte múltiples puntos característicos de la cara en la imagen para que se acerquen a las posiciones de los puntos característicos en la imagen frontal. Sin embargo, la cantidad de rotación, ampliación / reducción y ajuste cambia dependiendo de dónde se seleccionan los puntos del rostro. Por ello, la tecnología analiza las áreas que tienen una influencia significativa en la detección de unidades de acción de la imagen de la cara capturada, y el grado de rotación, ampliación y reducción se ajustan, en consecuencia. Al utilizar diferentes procesos de normalización para cada unidad de acción individual se consigue también mayor precisión.

Según Fujitsu, esta tecnología ha logrado una tasa de precisión de detección del 81%, incluso con datos de entrenamiento limitados. El fabricante en principio tiene como objetivo introducir la tecnología en aplicaciones prácticas como la teleconferencia, la “medición del compromiso de los empleados” y la supervisión de conductores, aunque no se detalla cuál sería el papel que cumpliría.